저번 포스팅에 이어 신경망의 동작원리를 알아보고자 한다. 만약에 신경망에 관한 기본개념이 없으면

신경망의 기본원리 를 보고오는걸 추천한다.

신경망( Neural Network ) 의 동작원리

신경망의 학습 과정은 퍼셉트론과 비슷하지만, 더 발전된 방법을 사용해한다.

- 순전파 (Forward Propagation)

- 입력 데이터가 입력층 → 은닉층 → 출력층 방향으로 전달됨.

- 각 뉴런에서 가중합을 구하고 활성화 함수를 적용해 다음 층으로 전달.

- 손실 계산 (Loss Calculation)

- 신경망의 예측값과 실제값을 비교해 오차(Loss)를 계산.

- 예: 이진 분류는 Binary Cross Entropy, 회귀 문제는 MSE(Mean Squared Error) 사용.

- 역전파 (Backpropagation) + 경사 하강법 (Gradient Descent)

- 오차를 줄이기 위해 가중치를 업데이트하는 과정.

- 역전파 알고리즘을 통해 가중치와 바이어스를 수정하면서 최적의 값을 찾아감.

간략하게 보면 이렇게 3단계로 나눌 수 있다.

하지만 이거만보고는 이해가안가니 좀더 살펴보고자한다.

먼저 저번 포스팅에 다룬 퍼셉트론의 동작 방식을 이해해야한다.

간략하게 정리해보면

퍼셉트론 동작 방식

- 입력값이 들어옴

- 입력값에 가중치를 곱함 → w1x1 + w2x2 + …

- 바이어스를 더해 가중합 구함 → w1x1 + w2x2 + …+b

- 가중합을 활성함수 태워서 최종 출력

이런식으로 작동하는데

이때 활성함수가 라는 생소한 단어가 등장하니 한번 짚고 넘어가보자

활성화 함수 (Activation Function)

활성화 함수(Activation Function) 는 신경망(Neural Network)의 뉴런(Neuron)이 출력 값을 결정하는 함수이다.

입력값을 가중치(weight)와 편향(bias)을 적용하여 계산한 후,

이 값이 활성화될지(출력을 생성할지) 여부를 결정하는 역할을 한다.

저번에 단일퍼셉트론의 한계점을 살펴볼때 XOR문제 같은 단순 선형문제만 해결하고 비선형문제는 불가능하다는 문제를

이 활성화 함수를 사용해 비 선형성을 도입하여 신경망이 복잡한 패턴을 학습할 수 있게 만드는것이다.

활성화 함수의 종류

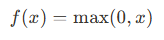

ReLU (Rectified Linear Unit)

- 장점: 계산이 간단하고, 기울기 소실 문제(vanishing gradient problem)를 완화한다.

- 단점: 음수 입력에 대해 기울기가 0이 되는 '죽은 ReLU' 문제가 발생할 수 있다.

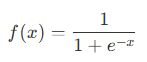

Sigmoid

- 장점: 출력 값이 0과 1 사이로 제한되어 확률을 표현하기에 적합하다.

- 단점: 기울기 소실 문제와 출력 값이 0 또는 1에 가까워질 때 학습이 느려지는 문제가 있다.

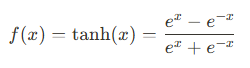

Tanh (Hyperbolic Tangent)

- 장점: 출력 값이 -1과 1 사이로 제한되어 중심이 0에 가까워진다.

- 단점: 기울기 소실 문제가 발생할 수 있다.

이제 활성함수까지 알았으니 신경망의 동작단계중 첫번째인 순전파 (Forward Propagation) 에 대해선 이해가 갈것이다

그러면 2단계인 손실 계산을 해야한다.

손실 계산은 단순하게 신경망의 예측값 과 실제값을 비교해 오차 를 계산하는 과정이다.

이때 계산을 하기위한 손실함수로 MSE 나 Cross-Entropy 가 사용된다.

MSE (Mean Squared Error)

- 사용 분야: 회귀 문제에서 주로 사용된다.

- 특징: 예측 값과 실제 값의 차이를 제곱하여 평균을 구한다.

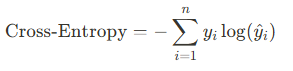

Cross-Entropy

- 사용 분야: 분류 문제에서 주로 사용된다.

- 특징: 예측 확률과 실제 클래스 간의 차이를 측정한다.

이제 2단계 까지했고 마지막 동작단계 역전파 + 경사하강법 을 거쳐야한다. 그래서 그 둘을 좀 살펴보려고한다.

역전파(Backpropagation)

- 역전파는 신경망의 가중치를 학습시키기 위해 사용되는 알고리즘이다.

- 출력에서 입력 방향으로 손실 함수의 기울기를 계산하고, 이를 바탕으로 가중치를 업데이트 한다.

간단하게 말하자면 이것인데

저번포스팅에서 퍼셉트론의 학습과정을 보았을 것이다.

초기 가중치를 랜덤으로 설정하기 때문에 순전파를 통해서 나온 예측값이 상당히 튈것이다.

그래서 이걸 줄여나가야하는데 이때 거꾸로 전파하는게 역전파 이다.

수학적 원리를 설명하자면

- 연쇄 법칙(Chain Rule)을 사용해 손실함수의 기울기를 계산한다.

- 각 층의 기울기는 이전 층의 기울기와 현재 층의 기울기를 곱하여 계산한다.

- 이를 통해 신경망의 모든 가중치가 업데이트 된다.

간략하게 보자면

- 순전파를 통해 예측값을 전달

- 예측값과 실제값의 차이를 비교 -> 손실계산 (MSE 같은 손실함수 사용)

- 가중치 수정을 위해 손실을 미분해 기울기계산

- 얻은 기울기를 거꾸로 전파 -> 역전파

- 은닉층에서 역으로 전파받은 기울기를 경사하강법을 통해 최적의 기울기 찾음

이러한 과정이고 위 방법을 반복한

순전파-역전파-순전파-역전파-......

를 진행하며 가중치화 편향을 구해서 최적의 가설식을 찾는것이다.

그리고 이러한 과정에서 역전파를 할때 활성함수 종류 중 시그모이드 함수 경우에는 기울기 소실 문제 가 있어서

ReLU 를 주로 사용한다.

또한 최적의 기울기를 찾기위해 경사하강법 을 이용하는데

이때 지역 최솟값에 빠지는 문제가 생길 수 있다.

이러한 문제점을 해결하기 위해 계속해서 새로운 최적화 알고리즘이 탄생하고 있다.

주요 최적화 알고리즘 으로는

- SGD (Stochastic Gradient Descent)

- 개념: 전체 데이터셋이 아닌 무작위로 선택된 일부 데이터(미니배치)를 사용하여 기울기를 계산하고 가중치를 업데이트한다.

- 장점: 계산이 빠르고, 큰 데이터셋에서도 효율적으로 동작한다.

- 단점: 최적점에 도달하기까지 진동이 발생할 수 있다.

- Adam (Adaptive Moment Estimation)

- 개념: 모멘텀과 RMSProp을 결합한 알고리즘으로, 학습률을 적응적으로 조정한다.

- 장점: 빠른 수렴 속도와 안정적인 학습을 제공한다.

- 단점: 하이퍼파라미터 설정이 복잡할 수 있다.

이러한 것이 있다.

'AI > DL' 카테고리의 다른 글

| [DL] 어텐션 (Attention) (0) | 2025.02.16 |

|---|---|

| [DL] 신경망 (ANN, DNN, RNN, CNN) (0) | 2025.02.12 |

| [DL] 신경망의 기본원리 (0) | 2025.01.24 |

| [DL] 딥러닝이란? (0) | 2025.01.09 |